En las últimas semanas, hemos sido testigos de cómo los deepfakes han sido utilizados para desacreditar a rivales políticos, creando vídeos y audios falsos con una precisión alarmante. Estos contenidos audiovisuales alterados, generados mediante inteligencia artificial, han provocado un aumento en la desinformación y la propagación de bulos. Sin embargo, la misma tecnología que permite la creación de estos contenidos también puede ser una herramienta poderosa en la lucha contra la desinformación.

La llegada de los deepfakes

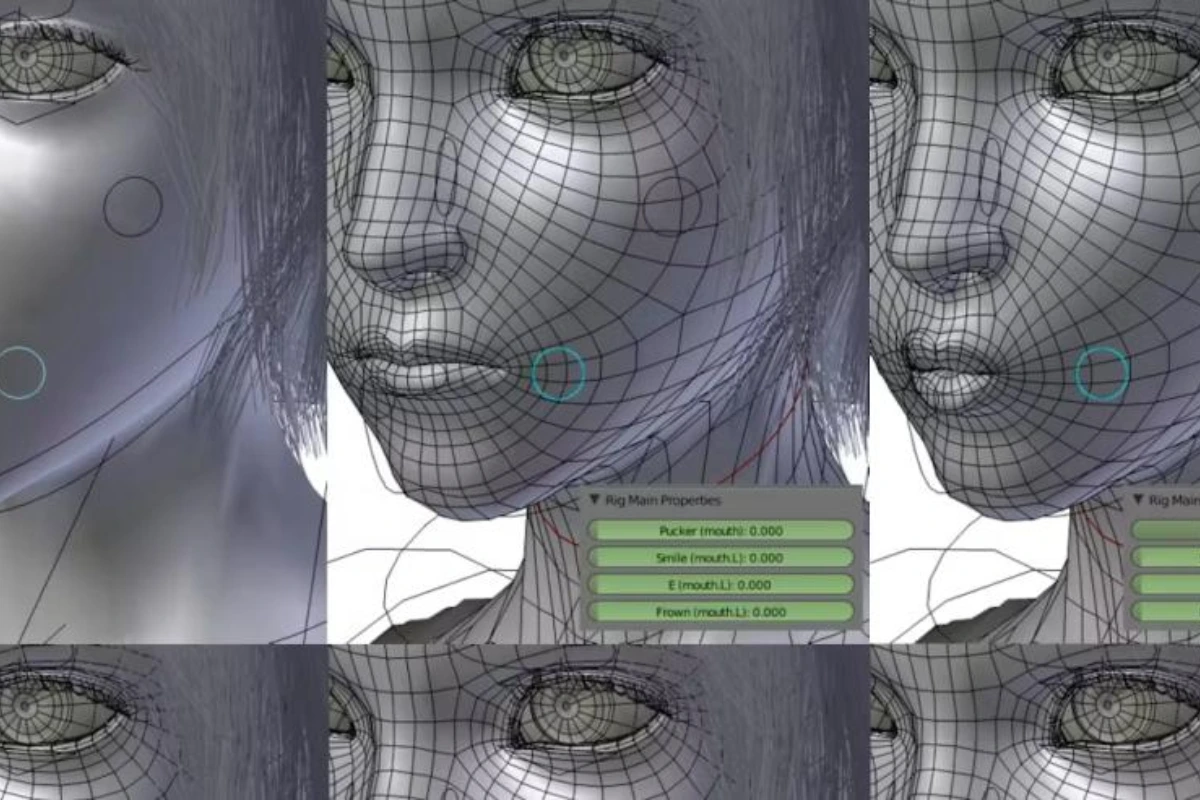

El término deepfake hace referencia a los contenidos visuales y sonoros creados o modificados mediante algoritmos de deep learning. A menudo, se alteran las expresiones faciales de personas conocidas o se combinan los rasgos de dos individuos. La primera ola de estos vídeos apareció en 2019, pero fue durante la pandemia de COVID-19 cuando realmente empezaron a ganar popularidad.

Un caso emblemático fue el de los vídeos falsos de un Tom Cruise virtual que se viralizaron en TikTok en 2021, sorprendiendo por la calidad y realismo de los contenidos generados. En 2024, estudios mostraron que los deepfakes eran cada vez más utilizados en campañas electorales, ya sea para promover a un candidato o para desacreditar a otro, como ocurrió en España.

¿Qué impacto tienen en la confianza pública?

Según un estudio reciente, los deepfakes afectan significativamente la confianza en los medios de comunicación. Tras ser informados de que una pieza audiovisual era un deepfake, los participantes del estudio mostraron una marcada desconfianza hacia el medio que lo había difundido. Sin embargo, los autores del estudio señalaron que no estaba claro si la exposición a estos contenidos afecta nuestra capacidad para distinguir entre lo real y lo falso.

Usar IA contra la desinformación

A pesar de los riesgos asociados a los deepfakes, la inteligencia artificial también puede ser una aliada en la lucha contra la desinformación. Los expertos sugieren usar tecnologías de procesamiento de lenguaje natural y aprendizaje automático para detectar inconsistencias en noticias falsas. Además, el análisis de sentimientos en textos puede ayudar a identificar contenido polarizado o manipulado en redes sociales.

Una de las principales ventajas de estas herramientas es su rapidez e inmediatez. A diferencia de los moderadores humanos, las IA pueden procesar grandes volúmenes de datos en tiempo real, lo que facilita la detección de patrones y el bloqueo de contenido nocivo de manera más eficiente.

Sin embargo, estas herramientas también tienen limitaciones. A menudo carecen de contexto para interpretar el lenguaje complejo o los dobles sentidos, lo que puede llevar a decisiones erróneas, y todavía enfrentan problemas al identificar deepfakes con baja calidad visual.

¿Es posible detectar deepfakes?

Aunque la regulación en Europa exige que los contenidos generados por inteligencia artificial sean identificados, la tecnología aún tiene mucho que mejorar en términos de detección. A pesar de los avances, los algoritmos que identifican deepfakes no siempre son efectivos, especialmente cuando los contenidos tienen baja calidad o están diseñados para eludir la detección.

Lo que está claro es que la generación de deepfakes continuará mejorando, con rostros, movimientos y voces humanos que serán más difíciles de diferenciar de los reales. La clave está en un uso responsable y ético de la inteligencia artificial, tanto en la creación como en la detección de este tipo de contenidos.